Anfang des Jahres sorgte eine Ankündigung von Mark Zuckerberg für Entrüstung: Meta stellte die bisherigen Faktenchecks ein und ersetzte sie durch sogenannte „Community Notes“. Das heißt wohl, dass die Suche nach rechtswidrigen Inhalten künftig von den Nutzern übernommen werden soll, was nicht zuletzt Meta einiges an Aufwand und Ärger ersparen könnte. Viele fragen: Wieso kann Meta eigenmächtig die Art der Prüfung von Inhalten ändern? Faktenchecks gehörten doch immer zu den Maßnahmen, mit denen die Plattformen ihre Verantwortung im Kampf gegen Desinformation und Hetze belegten? Die Antwort auf diese Frage ist einfach: Ja, Content-Moderation erfolgt im aktuellen Regulierungskonzept auf Grundlage unverbindlicher Selbstverpflichtungen. Höchste Zeit, darüber nachzudenken, die Plattformen mehr in die Verantwortung zu nehmen. Ein Vorschlag.

In einer funktionierenden Markt- und Gesellschaftsordnung ist es selbstverständlich: Wer ein Produkt auf den Markt bringt, haftet dafür, dass von dem Produkt kein Schaden für Dritte ausgeht. So hat beispielsweise die Bahn Verkehrssicherungspflichten, die bei Nichtbeachtung zur Haftung führen. Und auch eine Zeitungsredaktion muss prüfen, ob von ihr veröffentlichte Leserbriefe möglicherweise Rechte Dritter verletzen.

Bei den Plattformen ist das anders. Hier beginnt die Verantwortung erst, wenn sie von einem Rechtsverstoß positiv Kenntnis haben, also von Nutzern oder auch der zuständigen Aufsicht, den Landesmedienanstalten, darauf hingewiesen werden. Und zwar in jedem einzelnen Fall. Dieses sogenannte „notice and takedown“ ist Ausdruck des allgemeinen Haftungsprivilegs von Plattformen, wie es in Europa seit über 25 Jahren besteht. Das Verfahren „Künast gegen Facebook“ ist nur ein prominentes Beispiel dafür, das gut illustriert, wie schwer es ist, rechtswidrige Social-Media-Inhalte ohne aktives Tätigwerden der Plattformen zuverlässig zu löschen.

Kein Interesse am Kampf gegen schädliche Inhalte

Das Problem ist auch Brüssel nicht unbekannt. Ende 2022 trat der europäische Digital Services Act (DSA) in Kraft – mit dem Ziel, dieses Problem besser in den Griff zu bekommen. Nur wenige Jahre später ahnen wir: Das Problem von Hass und Hetze, von gezielter Verbreitung rechtswidriger Inhalte lässt sich – leider – auch mit einer zentralisierten, europäischen Lösung nicht lösen. Im Gegenteil. Funktionierende und seit Inkrafttreten des Medienstaatsvertrags 2020 etablierte Mechanismen der Löschung rechtswidriger, teilweise menschenverachtender Inhalte, die seit dem Angriff der Hamas auf Israel nochmals in die Höhe geschnellt sind, funktionieren immer weniger.

Woran liegt das? Die desillusionierende Wahrheit: Die Plattformen haben schlicht kein Interesse daran, sich in den Kampf gegen schädliche Inhalte einzubringen. Und das hängt nicht zuletzt mit dem Haftungsprivileg zusammen, an dem auch der DSA nichts ändert. Denn er konkretisiert zwar die Pflichten der Plattformen im Rahmen des Haftungsprivilegs. Aber an dem grundsätzlichen System „notice and takedown“ ändert der DSA nichts, er zementiert es noch.

Das ist kontraproduktiv, zumal die Privilegierung von Plattformen von überholten Annahmen ausgeht. Die Praxis zeigt: Plattformen sind längst keine neutralen Mittler fremder Inhalte mehr. Sie nutzen vielmehr ihre Algorithmen, um zu entscheiden, welche Inhalte wie und nach welchen Kriterien in die Timeline eingespeist werden. Und das tun sie durchaus aktiv: Sie entscheiden, ob und wie viel Desinformation und Hassrede verbreitet wird. Dabei ist es kein Geheimnis, dass polarisierende und spaltende Inhalte besonders profitabel sind.

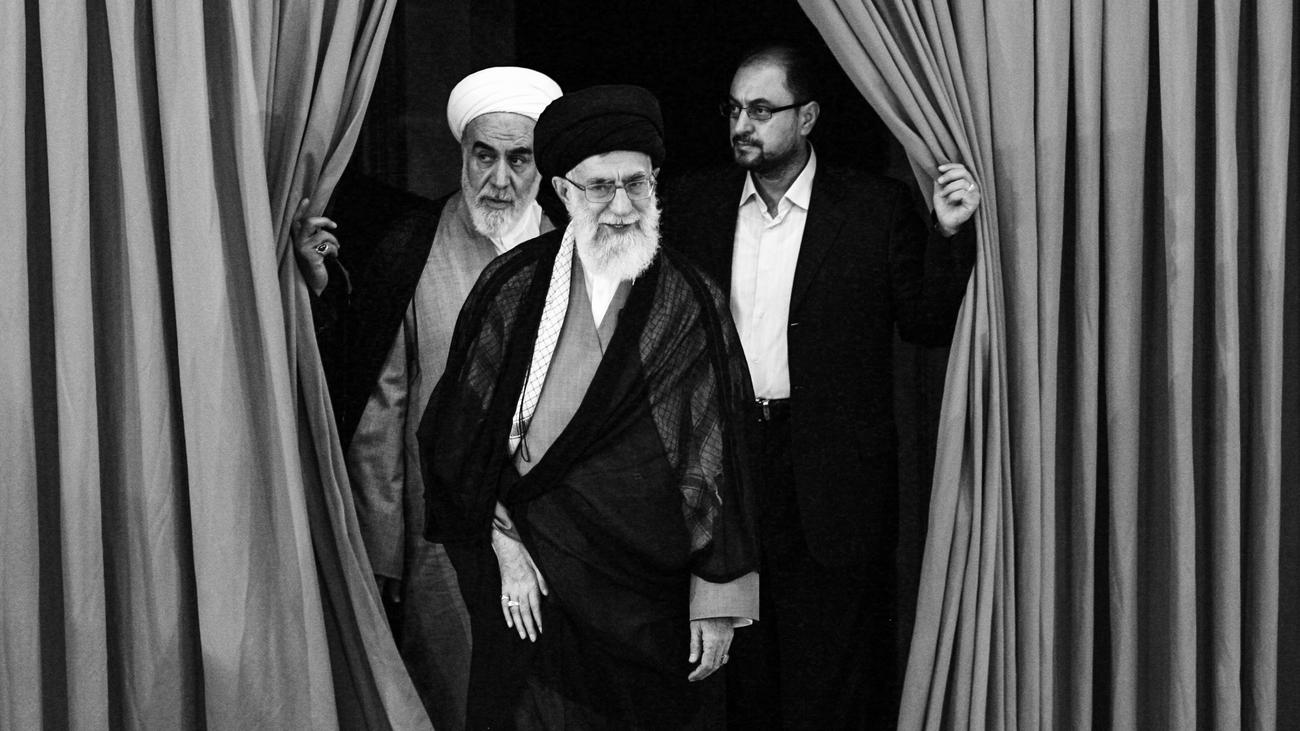

Thorsten Schmiege, Präsident der Bayerischen Landeszentrale für neue Medien (BLM) und stellvertretender Vorsitzender der Direktorenkonferenz der Landesmedienanstalten (DLM) sowie der Kommission für Zulassung und Aufsicht (ZAK).dpa

Thorsten Schmiege, Präsident der Bayerischen Landeszentrale für neue Medien (BLM) und stellvertretender Vorsitzender der Direktorenkonferenz der Landesmedienanstalten (DLM) sowie der Kommission für Zulassung und Aufsicht (ZAK).dpaWertvolle Reichweite, mit der Plattformen sehr viel Geld verdienen und letztlich auch groß geworden sind. Fast 50 Prozent des deutschen Netto-Werbeumsatzes von insgesamt 30,9 Milliarden Euro werden 2025 an Google, Meta und Amazon gehen, prognostiziert der Verband „Die Mediaagenturen“.

Man muss Meta fast dankbar sein: Mark Zuckerberg hat mit dem öffentlichkeitswirksamen Ausstieg aus dem Fakten-Checking das Augenmerk auf die bestehende und längst überholte Haftungslücke gelenkt. Historisch wurde das Haftungsprivileg aus der E-Commerce-Richtlinie übernommen. Es geht in die Zeit Anfang des Jahrtausends zurück, als Plattformen keinen (messbaren) Einfluss auf die Meinungsbildung hatten, die dahinterstehende Technologie neu war und die Betreiber auch technisch keine Möglichkeit hatten, Inhalte zu prüfen oder auf die Vermittlung von Inhalten Einfluss zu nehmen.

Inhalte auf X, Facebook oder Tiktok führen es uns tagtäglich vor Augen: Das Bild, dass Plattformen neutrale Mittler fremder Inhalte sind, ist falsch und zunehmend gefährlich. Plattformen sind eben nicht mit einem Schwarzen Brett in der analogen Welt, an das andere willkürlich Zettel heften, zu vergleichen. Tatsache ist vielmehr: Sie haben einen großen Einfluss darauf, welche Inhalte verbreitet und ob sie gelöscht werden. Und: Sie nutzen diesen Einfluss zunehmend auch ganz gezielt und teilweise politisch motiviert.

Weg mit den Privilegien!

Der erste Reflex könnte darin bestehen, mehr Regulierung von Plattformen zu fordern. Doch wie sieht die aus? Noch mehr Regulierung, die im Ergebnis immer schwerer durchzusetzen ist – vor allem, wenn sie von den größten Playern ignoriert oder abgelehnt wird?

Ich bin da – auch wenn es erst mal überraschen mag – eher beim US-Vizepräsidenten J. D. Vance. „Die kleinteiligen Regulierungsvorschriften des DSA bringen uns nicht weiter.“ Und: „Der DSA muss weg.“ Das waren zwei seiner Forderungen auf dem Pariser AI Summit im Februar. Auch wenn seine Begründung, die EU schränke damit die Meinungsfreiheit im Internet ein, natürlich abwegig ist. In Einem aber hat er möglicherweise nicht ganz unrecht: Im Bemühen, die Pflichten von „notice and takedown“ im DSA zu konkretisieren, wurde das Interesse der Plattformen weiter darauf reduziert, nur das umzusetzen, wozu sie nach Kenntnisnahme verpflichtet sind, oder wie man sich bei ihnen beschweren kann. Das wird ihrer Relevanz für die Meinungsbildung aber bei weitem nicht gerecht.

Wenn wir weiter nur auf freiwillige Community-Standards und Transparenz setzen, wird sich nichts ändern. Und auch die Regulierung diesbezüglich hochzufahren wird nichts bringen, wenn schon das Grundprinzip nicht funktioniert. Mein Vorschlag daher: Weg mit den Privilegien! In der Online-Welt muss das greifen, was in der analogen Welt Recht und Gesetz ist. Bei rechtswidrigen Inhalten sollte deshalb offline wie online agiert und nicht nur reagiert werden.

Mir ist klar, dass dafür ein Paradigmenwechsel nötig ist: Das Haftungsprivileg der Plattformen ist überholt. Stattdessen sollte man die Verpflichtung der Plattformen konkretisieren, für strafbare Inhalte zu haften. So wird die Verantwortung „umgedreht“. Das entbürokratisiert, und heraus kommt ein System, in dem alle Medienhäuser nach den gleichen Prinzipien und entsprechend ihres Einflusses in die Verantwortung genommen werden. Will eine Plattform nicht selbst haften, kann sie entsprechende Kontrollmechanismen, etwa technische Mittel wie im Jugendschutz, einsetzen.

Der Schutz des freien politischen Meinungsbildungsprozesses ist von klassischen Medien wie Rundfunk und Presse auf Social Media zu übertragen. Damit wird ganz nebenbei ein großer Schritt in Richtung Level-Playing-Field in einer konvergenten Medienwelt gemacht. Der Koalitionsvertrag von CDU, CSU und SPD enthält dazu übrigens eine wenig beachtete, aber vollkommen unterschätzte Vereinbarung: Die „verschärfte Haftung von Plattformen für Inhalte soll geprüft“ werden. Die Abschaffung des Plattformprivilegs auch auf europäischer Ebene wäre hier ein Durchbruch.

Die Wette gilt: Erst wenn die Plattformen genauso wie die Leserbriefseite jeder Zeitung haften, werden sie mehr Sorge dafür tragen, dass illegale Inhalte entfernt werden.

Thorsten Schmiege ist Präsident der Bayerischen Landeszentrale für neue Medien (BLM) und stellvertretender Vorsitzender der Direktorenkonferenz der Landesmedienanstalten (DLM) sowie der Kommission für Zulassung und Aufsicht (ZAK).

vor 21 Stunden

2

vor 21 Stunden

2

English (US) ·

English (US) ·